1. 정합성 체크를 통한 데이터 품질향상, 데이터 프로파일링의 개요

가. 데이터 프로파일링(Profiling)의 정의

- 데이터에 기반한 정합성을 체크하여 데이터를 구조화하고 보정하는 분석 기법

나. 데이터 프로파일링의 목적

- 데이터정확성 : 비즈니스 사용자에게 정확한 데이터 제공

- 데이터 제어 : 이름, 주소 등 비즈니스 데이터에 대한 정제, 표준화, 보강 및 중복제거

- 데이터 모니터링 : 분석기능을 통한 지속적인 데이터 품질평가 및 변경 내역에 대한 모니터링 제공

2. 데이터 프로파일링 개념도 및 기법

가. 데이터 프로파일링 개념도

- 소스데이터를 효과적으로 분석하기 위해서 데이터 프로파일을 통해서 데이터 오류를 식별

- 데이터 크린싱(Cleansing)을 통해서 검출된 오류 데이터를 변경 및 수정 실행

나. 데이터 프로파일링 절차 및 기능요소

- 대상선정 : 데이터 프로파일링에 필요한 데이터를 선정

- 데이터 탐색 : 데이터의 값이 업무 규칙과 정합성을 유지하는지 확인

- 구조 탐색 : 테이블 사이의 무결성과 데이터 레코드 내의 구조적 이상확인

- 관계 탐색 : 컬럼과 테이블간 관계(Relation)의 관계분석

- 결과 리포트 : 발견된 데이터 오류정보를 사용자 및 Cleansing모듈에 전달

다. 데이터 프로파일링 기법

- 컬럼속성분석 : 하나의 컬럼에 저장된 값 분석

- 구조 분석 : 테이블을 서로 어떤 관련인지를 정의한 룰 사용

- 단순데이터 룰 분석 : 값의 결합이 가능한 비즈니스 객체의 여러 컬럼에 걸친 값을 다루는 룰을 분석하여 보다 유용한 것을 찾는 것

- 복잡한 데이터 룰 분석 : 여러 비즈니스 객체에 연관된 데이터 룰에 부합하는 값을 요구하는 것 보다 복잡한 룰

- 값 룰 분석 : 합당하지 않는 집계 값에서 부정확한 데이터의 존재를 찾는 것

'1. IT Story > Basic Studies' 카테고리의 다른 글

| CAP(Consistency, Availability, Partitioning) 이론 (0) | 2020.12.24 |

|---|---|

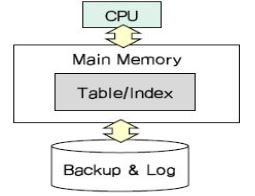

| MMDB(Main Memory Data Base) (0) | 2020.12.24 |

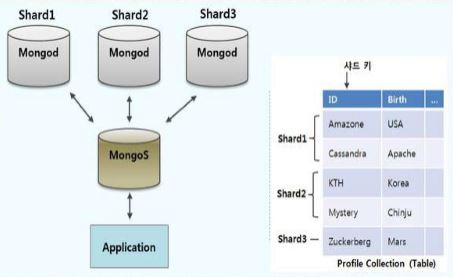

| DB 샤딩(Sharding) (0) | 2020.12.24 |

| CI(Continuous Integration) (0) | 2019.11.21 |

| 테스트자동화 (0) | 2019.09.22 |

| V&V(Verification & Validation) (0) | 2019.09.20 |

| 빅데이터(Big Data) (0) | 2019.09.19 |

| 3D프린팅 (0) | 2019.09.17 |